- Lundi à la WWDC, Apple a habilement annoncé le travail qu’il faisait sur les dernières technologies d’IA et d’apprentissage automatique.

- Contrairement à la plupart des entreprises technologiques alimentées par l’IA, Apple effectue un traitement de pointe sur ses appareils plutôt que de s’appuyer sur le cloud.

- Plutôt que de parler de modèles et de technologies d’IA, se concentrer sur un produit Apple signifie qu’il ne fait généralement que montrer de nouvelles fonctionnalités qui sont discrètement activées par l’IA dans les coulisses.

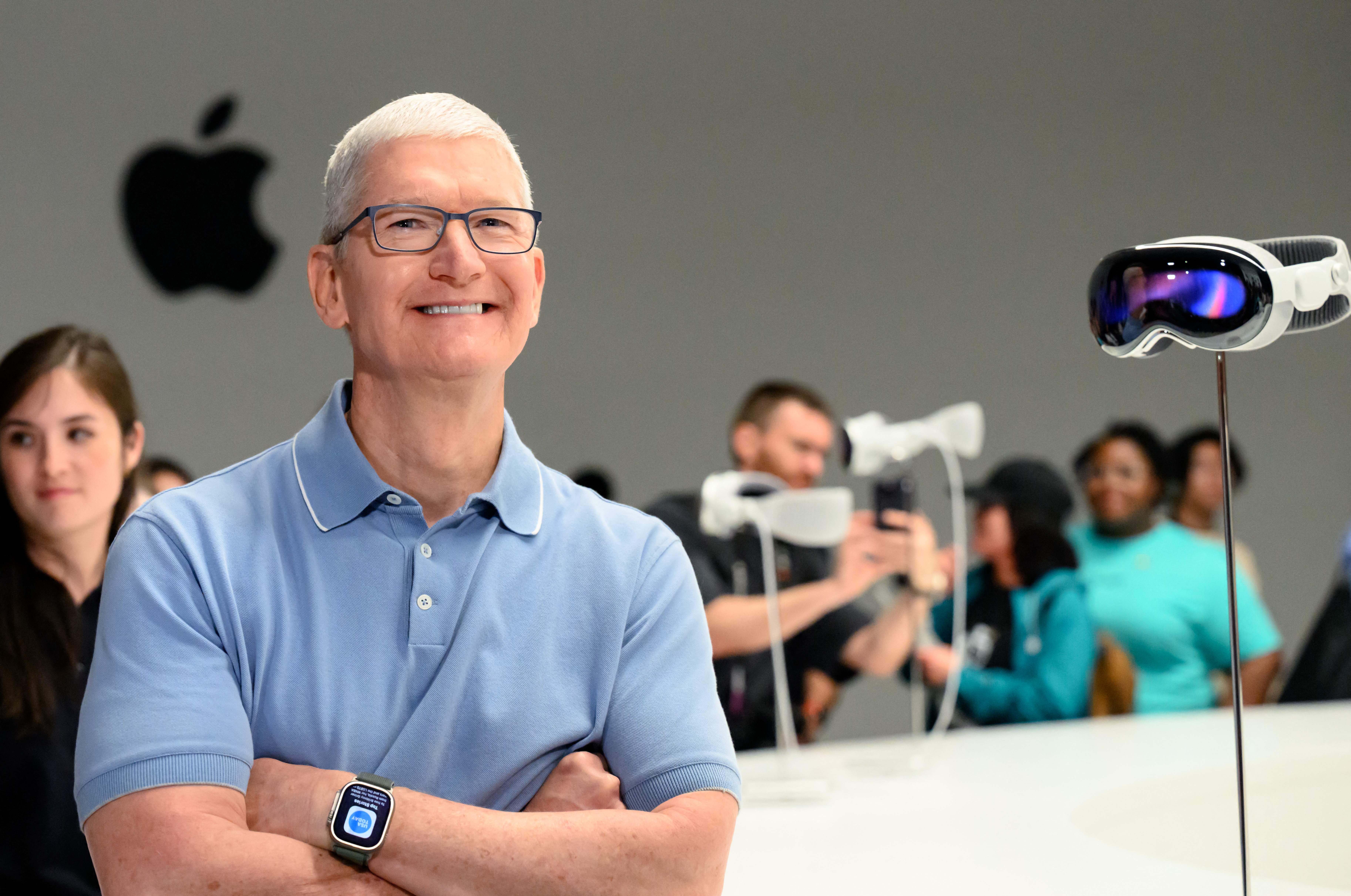

Apple Park est vu avant la Worldwide Developers Conference (WWDC) à Cupertino, en Californie, le 5 juin 2023.

Josh Adelson | AFP | Getty Images

Lundi, lors de la conférence annuelle des développeurs WWDC d’Apple, la société a révélé l’ampleur du travail qu’elle effectuait sur les dernières technologies d’IA et d’apprentissage automatique.

Alors que Microsoft, Google et des startups comme OpenAI ont adopté des technologies d’apprentissage automatique de pointe comme les chatbots et l’IA générative, Apple a semblé rester sur la touche.

Mais lundi, Apple a annoncé plusieurs fonctionnalités d’intelligence artificielle importantes, notamment la correction automatique de l’iPhone basée sur un logiciel d’apprentissage automatique utilisant un modèle de langage d’adaptateur, la même technologie qui sous-tend ChatGPT. Apple a déclaré qu’il apprendrait même de la façon dont l’utilisateur fait des scripts et des types à améliorer.

Craig Federighi, directeur des logiciels d’Apple, a plaisanté sur la tendance d’AutoCorrect à utiliser le mot absurde « esquiver » pour remplacer un juron commun.

La plus grande nouvelle de lundi était son nouveau casque de réalité augmentée, le Vision Pro, mais Apple a néanmoins montré comment cela fonctionne et s’intéresse aux développements des dernières technologies d’apprentissage automatique et d’intelligence artificielle. Le ChatGPT d’OpenAI a peut-être atteint plus de 100 millions d’utilisateurs en deux mois lors de son lancement l’année dernière, mais Apple utilise maintenant la technologie pour améliorer une fonctionnalité utilisée par 1 milliard de propriétaires d’iPhone chaque jour.

Contrairement à ses concurrents, qui construisent des modèles plus grands avec des fermes de serveurs, des superordinateurs et des téraoctets de données, Apple veut des modèles d’IA sur ses appareils. La nouvelle fonctionnalité de correction automatique est particulièrement impressionnante car elle fonctionne sur l’iPhone, tandis que des modèles comme ChatGPT nécessitent des centaines de GPU coûteux fonctionnant en tandem.

L’IA sur l’appareil contourne de nombreux problèmes de confidentialité des données rencontrés par l’IA basée sur le cloud. Lorsqu’un modèle peut être exécuté sur un téléphone, Apple doit collecter moins de données pour l’exécuter.

Il est également étroitement lié au contrôle d’Apple sur son portefeuille de matériel, jusqu’à ses puces en silicium. Apple intègre chaque année de nouveaux circuits IA et GPU dans ses puces, et son contrôle sur l’architecture globale lui permet de s’adapter aux changements et aux nouvelles technologies.

Apple n’aime pas parler « d’intelligence artificielle » – ils préfèrent l’expression académique « apprentissage automatique » ou parlent simplement de l’avantage que la technologie permet.

Certaines des autres grandes entreprises d’IA ont des dirigeants issus de milieux universitaires. Cela vous a amené à vous concentrer sur la présentation de votre travail, à expliquer comment il peut s’améliorer à l’avenir et à le documenter afin que d’autres puissent l’étudier et s’en inspirer.

Apple est une entreprise de produits, et elle est très secrète depuis des décennies. Plutôt que de parler du modèle d’IA spécifique, des données de formation ou de la façon dont il pourrait s’améliorer à l’avenir, Apple mentionne simplement la fonctionnalité et dit qu’une excellente technologie fonctionne dans les coulisses.

Un exemple de ce lundi est une amélioration d’AirPods Pro qui désactive automatiquement la suppression du bruit lorsqu’un utilisateur est engagé dans une conversation. Apple ne l’a pas présenté comme une fonctionnalité d’apprentissage automatique, mais il est difficile à résoudre et la solution est basée sur des modèles d’intelligence artificielle.

Dans l’une des fonctionnalités les plus audacieuses annoncées lundi, la nouvelle fonctionnalité Digital Persona d’Apple scanne le visage et le corps d’un utilisateur en 3D, et peut ensuite recréer virtuellement à quoi il ressemble lors d’une visioconférence avec d’autres personnes tout en portant un casque Vision Pro.

Apple a également mentionné plusieurs autres nouvelles fonctionnalités qui utilisaient les compétences de l’entreprise dans les réseaux de neurones, telles que la possibilité de sélectionner des champs pour remplir un PDF.

L’une des plus grandes acclamations de l’après-midi à Cupertino a été la fonction d’apprentissage automatique qui permet à l’iPhone de reconnaître votre animal de compagnie – par rapport à d’autres chats ou chiens – et de mettre toutes les photos d’animaux de compagnie d’un utilisateur dans un dossier.